爬虫软件用到哪些技术,爬虫软件可以爬哪些数据

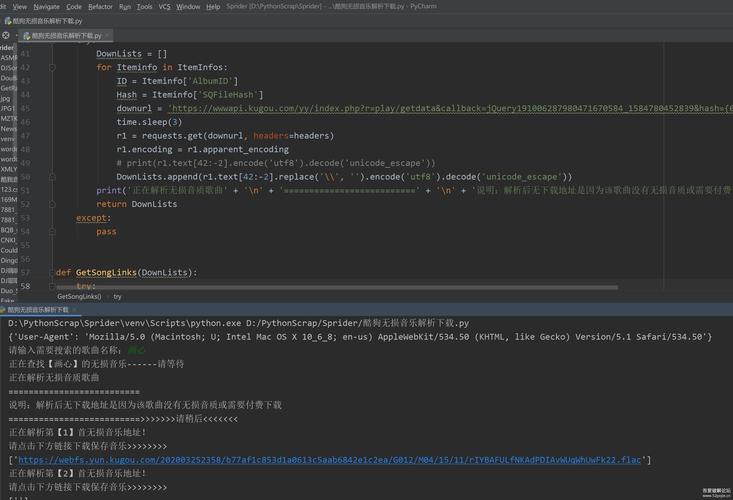

定义Python爬虫,即使用Python语言编写的网络爬虫,是一种程序,用于自动访问互联网上的网页并抓取其中的内容用途它是搜索引擎的基础,如百度GOOGLE等,利用爬虫技术检索互联网信息,存储于云端,

定义Python爬虫,即使用Python语言编写的网络爬虫,是一种程序,用于自动访问互联网上的网页并抓取其中的内容用途它是搜索引擎的基础,如百度GOOGLE等,利用爬虫技术检索互联网信息,存储于云端,为用户提供搜索服务此外,企业也常利用爬虫技术获取用户反馈分析用户偏好,以支持产品迭代和市场策略调。

(图片来源网络,侵删)

由于爬虫软件在互联网上广泛爬取信息,其行为类似于一只在网络中穿梭的大蜘蛛,因此有时也被称为“网络蜘蛛”或“网络爬虫”应用场景爬虫软件是搜索引擎的重要组成部分,它帮助搜索引擎收集互联网上的信息,并建立索引除了搜索引擎,爬虫软件还可以用于数据挖掘信息聚合价格监测等多种场景性能评估。

蜘蛛也可以在web上用来自动执行一些任务,例如检查链接,确认html代码也可以用来抓取网页上某种特定类型信息,例如抓取电子邮件地址通常用于垃圾邮件一个网络蜘蛛就是一种机器人,或者软件代理大体上,它从一组要访问的URL链接开始,可以称这些URL为种子爬虫访问这些链接,它辨认出这些页面的所有。

爬虫可以做的是以下四种1收集数据Python爬虫程序可用于收集数据,这是最直接和最常用的方法由于爬虫程序是一个程序,程序运行得非常快,不会因为重复的事情而感到疲倦,因此使用爬虫程序获取大量数据变得非常简单快速2数据储存Python爬虫可以将从各个网站收集的数据存入原始页面数据库其中的。

相关文章

发表评论

评论列表

- 这篇文章还没有收到评论,赶紧来抢沙发吧~